- El espacio de hipótesis es completo, la función objetivo está incluida en él.

- Selecciona una única hipótesis:

- No es capaz de determinar todos los árboles compatibles con los ejemplos de entrenamiento.

- No se puede proponer ejemplos que reduzcan el espacio de búsqueda.

- No hay vuelta atrás:

- Encuentra un óptimo local que puede no ser el óptimo global (hill-climbing).

- En cada paso utiliza información estadística de todos los ejemplos en lugar de considerar los ejemplos uno a uno:

- Permite ruido en los datos de entrenamiento.

- Por la ganancia de información, tiene tendencia a elegir atributos con muchos valores.

- De todos los árboles compatibles con los ejemplos de entrenamiento ¿Cuál elige ID3?

- ID3 prefiere árboles cortos frente a largos, con los atributos que producen una mayor ganancia de información cerca de la raíz.

Fuentes de mejora de ID3

- Cuándo parar en la construcción del árbol

- Uso de atributos continuos

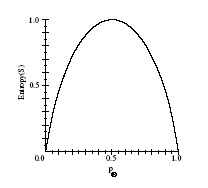

- Otras medidas de selección de atributos

- Atributos con coste diferente

- Ejemplos incompletos