¿Qué es la entropía?

Dados:

- Un problema con dos clases (positiva y negativa)

- S, el conjunto de ejemplos.

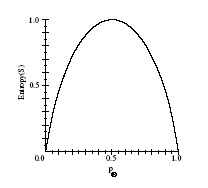

Entropia(S)= ∑i =1 hasta k pi ⋅ log2 (1 / pi )

con k clases

¿Qué es la ganacia de información?

Es la diferencia entre la cantidad de información que se necesita para hacer una clasificación antes de hacer la división y después.

Se calcula determinando la diferencia entre la entropía del conjunto de datos de partida y la suma ponderada de las entropías una vez dividido el conjunto de ejemplos.

No hay comentarios:

Publicar un comentario